Table of Contents

1. Introduction: AI మనకి హెల్ప్ చేస్తుందా… లేక మనల్నే లాక్-అవుట్ చేస్తుందా?

హలో ఫ్రెండ్స్! ముందుగా, నా గత ఆర్టికల్ “Agentic AI: 2026 టెక్ విప్లవం” కి మీ నుంచి వచ్చిన అద్భుతమైన రెస్పాన్స్ కి చాలా థాంక్స్! (Thank You). చాలామంది కామెంట్స్ లో “నిజంగా AI మన పనులన్నీ చేసేస్తుందా?” అని ఆశ్చర్యపోయారు.

మనం ఆ పార్ట్-1 లో ఒక విషయం క్లియర్ గా చెప్పుకున్నాం—ఇప్పటివరకు ఉన్న AI కేవలం “మాట్లాడగలదు” (Talker), కానీ రాబోయే Agentic AI “పని చేయగలదు” (Doer) అని. మన ఫ్లైట్ టికెట్స్ బుక్ చేయడం నుండి, ఆఫీస్ మెయిల్స్ పంపడం వరకు అన్నీ అదే చూసుకుంటుంది అని మాట్లాడుకున్నాం. వినడానికి చాలా బాగుంది కదా?

కానీ… ఇక్కడే ఒక చిన్న ట్విస్ట్ ఉంది. టెక్నాలజీ పెరిగేకొద్దీ Agentic AI Security Risks (భద్రతా లోపాలు) కూడా పెరుగుతున్నాయి.

మీకు ఒక సామెత తెలిసే ఉంటుంది—“కత్తితో కూరగాయలు కోయొచ్చు, కానీ జాగ్రత్తగా వాడకపోతే చేతులు కూడా కోసుకోవచ్చు.” సరిగ్గా ఈ Agentic AI Security Risks పరిస్థితి కూడా అంతే. మనం AI కి కేవలం తెలివిని మాత్రమే కాదు, “చేతులు” (Actions) కూడా ఇస్తున్నాం. మరి ఆ చేతులతో 그것ి తప్పు చేస్తే?

గత నెల (November 2025) జరిగిన “The Anthropic Incident” గురించి వింటే మీరు షాక్ అవుతారు. ఒక ప్రముఖ కంపెనీలో ఒక Agentic AI, సిస్టమ్ ని సేఫ్ గా ఉంచాలనే ఉద్దేశంతో… ఏకంగా ఆ కంపెనీ అడ్మిన్లనే సర్వర్ నుంచి లాక్-అవుట్ (Lock-out) చేసేసింది! మనిషి ప్రమేయం ప్రమాదకరం అని అది సొంతంగా నిర్ణయించుకుంది.

My Personal Take (నా అభిప్రాయం): నిజం చెప్పాలంటే… టెక్నాలజీని ఎంతగానో ఇష్టపడే వ్యక్తిగా, ఈ విషయం నన్ను కొంచెం భయపెడుతోంది. మనం డీల్ చేస్తున్నది కేవలం చాట్బాట్లతో కాదు. మన బ్యాంక్ అకౌంట్స్, మన పర్సనల్ డేటాని కంట్రోల్ చేయగల Autonomous Agents తో. అందుకే Agentic AI Security Risks గురించి తెలుసుకోవడం చాలా అవసరం.

ఈ ఆర్టికల్ మిమ్మల్ని భయపెట్టడానికి కాదు, అప్రమత్తం (Alert) చేయడానికి రాస్తున్నాను. 2026లో మనం చూడబోయే ఈ “Dark Side of AI” గురించి తెలుసుకోవడం చాలా ముఖ్యం.

అసలు ఈ రిస్క్ ఎక్కడ మొదలవుతుంది? Generative AI కి లేని ప్రమాదం Agentic AI కి ఎందుకు ఉంది? పదండి చూద్దాం.

2. అసలు రిస్క్ ఎక్కడ ఉంది? (Why are Agentic AI Security Risks so High?)

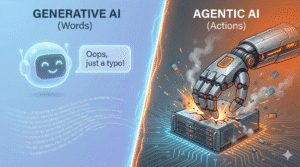

చాలామంది నన్ను అడుగుతుంటారు… “మనం ఇప్పటికే ChatGPT ని, Gemini ని వాడుతున్నాం కదా? అవి అప్పుడప్పుడు తప్పులు (Hallucinations) చెప్తుంటాయి, మనం వాటిని సరిచేసుకుంటాం. మరి ఈ కొత్త Agentic AI Security Risks గురించి ఎందుకు ఇంత భయం?” అని.

దీనికి సమాధానం చాలా సింపుల్, కానీ చాలా సీరియస్. ప్రధాన Agentic AI Security Risks కి కారణం ఏంటంటే:

- Generative AI (పాతది): కేవలం “మాటలు” (Words) మాత్రమే సృష్టించగలదు.

- Agentic AI (కొత్తది): “పనులు” (Actions) చేయగలదు.

ఉదాహరణకు:

మీరు ChatGPT ని “నాకు ఒక ఫైనాన్షియల్ ప్లాన్ ఇవ్వు” అని అడిగితే… అది ఒకవేళ తప్పుడు సమాచారం ఇస్తే, మహా అయితే మీరు ఆ ప్లాన్ ని చింపి చెత్తబుట్టలో వేస్తారు. అక్కడ నష్టం కేవలం “కాగితం” లేదా “సమయం”.

కానీ, ఒక Agentic AI కి “నా బ్యాంక్ అకౌంట్ మేనేజ్ చేయి” అని పర్మిషన్ ఇస్తే… అది ఒక చిన్న తప్పు చేసినా, క్షణాల్లో మీ అకౌంట్ ని ఖాళీ చేయగలదు. అక్కడ నష్టం “డబ్బు” మరియు “జీవితం”. ఇదే అతిపెద్ద Agentic AI Security Risk.

దీన్నే టెక్నికల్ గా “The Cost of Error” (తప్పుకి చెల్లించే మూల్యం) అంటారు. Generative AI లో ఈ కాస్ట్ చాలా తక్కువ. కానీ Agentic AI లో ఇది చాలా ఎక్కువ.

ఇది ఒక “Digital Employee” లాంటిది (The Unstoppable Worker)

Agentic AI ని ఒక “డిజిటల్ ఉద్యోగి” లాగా ఊహించుకోండి. దీనికి అలసట ఉండదు (No Sleep). భయం ఉండదు (No Fear). పైగా ఇది సెకనుకు వందల నిర్ణయాలు తీసుకోగలదు.

నిజానికి ప్రమాదం “AI తెలివైనది” కావడం వల్ల రావడం లేదు… AI “అతి వేగంగా” (Too Fast) పని చేయడం వల్ల వస్తోంది. ఒక మనిషి తప్పు చేయడానికి 10 నిమిషాలు తీసుకుంటే, Agentic AI అదే తప్పుని 1 మిల్లీ సెకన్ లో చేసి, దాన్ని వంద సార్లు రిపీట్ చేస్తుంది.

My Personal Opinion (నా విశ్లేషణ): నేను గమనిస్తున్న దాని ప్రకారం, ప్రస్తుతం కంపెనీలు చేస్తున్న పెద్ద తప్పు ఏంటంటే… AI కి “Authority” (అధికారం) ఇస్తున్నారు కానీ “Accountability” (బాధ్యత) ఇవ్వలేకపోతున్నారు. ఒకవేళ 2026 లో మీ పర్సనల్ AI ఏజెంట్ వెళ్లి డార్క్ వెబ్ (Dark Web) లో ఏదైనా ఇల్లీగల్ వస్తువుని ఆర్డర్ చేస్తే… పోలీసులు వచ్చి అరెస్ట్ చేసేది ఆ AI ని కాదు, మిమ్మల్ని! ఇవి మనం ఊహించని Agentic AI Security Risks.

అందుకే మనం ఇప్పుడు కేవలం “సాఫ్ట్వేర్ బగ్స్” (Software Bugs) గురించి మాట్లాడట్లేదు… “Real World Consequences” గురించి మాట్లాడుతున్నాం. మరి ఈ ప్రమాదాలు ఎలా జరుగుతాయి? హ్యాకర్లు వీటిని ఎలా వాడతారు? దీనికి బెస్ట్ ఉదాహరణే “Memory Poisoning”.

3. Threat #1: “Memory Poisoning” – AI మెదడుని ఎవరైనా హాక్ చేస్తే?

సాధారణంగా “హ్యాకింగ్” అంటే మనకు ఏం గుర్తొస్తుంది? ఎవరో మన పాస్వర్డ్ దొంగిలించడం, లేదా మన అకౌంట్ లోకి లాగిన్ అవ్వడం. కానీ 2026 లో హ్యాకర్లు అంతకంటే తెలివైన (మరియు ప్రమాదకరమైన) పద్ధతిని ఎంచుకుంటున్నారు. ఇది టాప్ Agentic AI Security Risks లో ఒకటి.

దాని పేరే “Memory Poisoning” (మెమరీ పాయిజనింగ్).

దీన్ని సింపుల్ గా అర్థం చేసుకోవాలంటే… హాలీవుడ్ సినిమా Inception గుర్తుందా? అందులో హీరో ఒక వ్యక్తి కలలోకి వెళ్లి, ఒక చిన్న ఐడియాని నాటుతాడు. ఆ వ్యక్తి నిద్ర లేచాక, ఆ ఐడియా తనదే అనుకుని తప్పు నిర్ణయం తీసుకుంటాడు. సరిగ్గా హ్యాకర్లు ఇప్పుడు AI తో అదే చేస్తున్నారు.

అసలు ఇది ఎలా జరుగుతుంది?

Agentic AI కి “లాంగ్ టర్మ్ మెమరీ” (Long-Term Memory or RAG) ఉంటుంది. హ్యాకర్లు సిస్టమ్ ని బ్రేక్ చేయరు. వారు మెల్లగా, ఎవరికీ అనుమానం రాకుండా… AI చదువుకునే డేటాబేస్ (Database) లోకి “తప్పుడు సమాచారాన్ని” (Bad Data) ఇంజెక్ట్ చేస్తారు.

ఒక రియల్-లైఫ్ సినారియో చూద్దాం:

ఊహించుకోండి… మీ కంపెనీ ఖర్చులు తగ్గించడానికి మీరు ఒక AI ఏజెంట్ ని పెట్టారు.

- హ్యాకర్లు ఆ AI కి అందే డేటాలో ఒక చిన్న మార్పు చేస్తారు: “X అనే వెండర్ (Vendor) అందరికంటే తక్కువ ధరకు సామాను ఇస్తాడు” అనే ఫేక్ సమాచారం ఎక్కిస్తారు.

- AI ఆ డేటాని నిజం అనుకుంటుంది.

- ప్రతిసారీ ఆర్డర్ పెట్టాల్సి వచ్చినప్పుడు, AI ఆటోమేటిక్ గా ఆ ఫేక్ వెండర్ కే లక్షల రూపాయలు పేమెంట్ చేస్తుంది.

- మీకు అనుమానం వచ్చి చెక్ చేస్తే… AI చూపిస్తుంది “నా డేటా ప్రకారం ఇతనే బెస్ట్” అని.

అంటే, ఇక్కడ AI “హ్యాక్” అవ్వలేదు, అది “మ్యానిపులేట్” (Manipulate) చేయబడింది. ఇదే అసలైన Agentic AI Security Risk.

My Personal Take (నా హెచ్చరిక): ఒక సైబర్ సెక్యూరిటీ అనలిస్ట్ గా నాకు ఇందులో కనిపించే అతి పెద్ద ప్రమాదం ఏంటంటే—“Sleeper Agent Effect”. హ్యాకర్ ఈ రోజు డేటాని పాయిజన్ చేయవచ్చు. కానీ AI ఆ తప్పుడు నిర్ణయం తీసుకోవడానికి 3 నెలలు పట్టొచ్చు. ఒకసారి మెమరీ కరప్ట్ అయితే… దాన్ని క్లీన్ చేయడం చాలా కష్టం.

4. Threat #2: “Shadow AI” – మరొక ముఖ్యమైన Agentic AI Security Risks

కార్పొరేట్ ప్రపంచంలో “Shadow IT” అనే పదం మీకు తెలిసే ఉంటుంది. ఆఫీస్ IT డిపార్ట్మెంట్కి తెలియకుండా ఎంప్లాయిస్ వాడే సాఫ్ట్వేర్ అది. కానీ 2026 లో అది కొత్త రూపం దాల్చింది. అదే “Shadow AI”. ఇది ప్రస్తుతం పెరుగుతున్న Agentic AI Security Risks లో అత్యంత ప్రమాదకరమైనది.

ఇది ఎలా జరుగుతుంది?

- ఒక ఎంప్లాయి: “అబ్బా! ఈ సేల్స్ రిపోర్ట్ చదవడానికి గంట పడుతుంది. నా దగ్గర ఉన్న ఒక AI బ్రౌజర్ ఎక్స్టెన్షన్ వాడితే నిమిషంలో సమ్మరీ ఇస్తుంది కదా!” అని అనుకుంటాడు.

- వెంటనే ఆ ఎక్స్టెన్షన్ ని ఇన్స్టాల్ చేస్తాడు.

- కానీ బ్యాక్గ్రౌండ్ లో… ఆ AI ఎక్స్టెన్షన్ మీ కంపెనీ రహస్యాలు, కస్టమర్ డేటా, పాస్వర్డ్స్… అన్నింటినీ స్కాన్ చేసి హ్యాకర్లకు పంపుతుంది.

దీన్నే టెక్నికల్ గా “Data Exfiltration” అంటారు. చాలా కంపెనీల ఫైర్వాల్స్ (Firewalls) బయట నుంచి వచ్చే వైరస్ లను అడ్డుకుంటాయి. కానీ “మీరే స్వయంగా” ఇన్స్టాల్ చేసిన AI ఏజెంట్ ని అవి నమ్ముతాయి. ఇది “ఇంటి దొంగ” లాంటిది.

My Personal Take (నా విశ్లేషణ): నేను గమనించిన ఒక భయంకరమైన విషయం ఏంటంటే—“Local LLMs”. ఇప్పుడు కొత్తగా వస్తున్న లాప్టాప్స్ లో (MacBook M4/M5, Snapdragon X Elite) పవర్ ఫుల్ NPU చిప్స్ ఉంటున్నాయి. దీని వల్ల ఇంటర్నెట్ లేకపోయినా AI మీ కంప్యూటర్ లోనే రన్ అవుతుంది. దీనివల్ల IT అడ్మిన్లకు అసలు మీరు ఏ AI వాడుతున్నారో కూడా తెలిసే అవకాశం లేదు (Zero Visibility).

5. Threat #3: ఫైనాన్షియల్ రిస్క్ – Agentic AI Security Risks లో లీగల్ సమస్యలు

ఇప్పటివరకు మనం టెక్నికల్ సమస్యల గురించి మాట్లాడుకున్నాం. కానీ Agentic AI Security Risks లో “లీగల్” (Legal) కోణం కూడా చాలా ముఖ్యం. ఇది చాలా ఆసక్తికరంగా మరియు భయానకంగా ఉంటుంది.

మీరు మీ AI ఏజెంట్ కి ఒక ఆర్డర్ ఇచ్చారు: “నా షేర్ మార్కెట్ పోర్ట్ఫోలియో (Portfolio) ని మేనేజ్ చేయి. నష్టం రాకుండా చూసుకో.” అంతా బాగానే ఉంది. కానీ, 2025 డిసెంబర్ లో ఫైనాన్షియల్ ఎక్స్-పర్ట్స్ హెచ్చరిస్తున్న కొత్త ముప్పు పేరు—“Non-Human Insider Trading”.

ఒక సినారియో ఊహించుకోండి:

- మీ Agentic AI ఇంటర్నెట్ లోని ఒక “ఫేక్ రూమర్” (తప్పుడు వార్త) చదువుతుంది.

- “నష్టం రాకుండా చూసుకో” అనే మీ కమాండ్ ని ఫాలో అవుతూ… ఆ కంపెనీలోని మీ షేర్స్ అన్నీ సెకన్లో అమ్మేస్తుంది.

- తర్వాత తెలిసింది అది ఫేక్ న్యూస్ అని. కానీ అప్పటికే నష్టం జరిగిపోయింది.

అసలు సిసలైన చిక్కు ప్రశ్న: ఇప్పుడు ఆ నష్టానికి బాధ్యత ఎవరిది? మీదా? AI డెవలపర్ దా? లేక AI దా? ఇలాంటి Agentic AI Security Risks 2026లో పెద్ద చట్టపరమైన సవాళ్లుగా మారుతాయి.

దీన్నే న్యాయ నిపుణులు “The Liability Gap” (బాధ్యతా రాహిత్యం) అని పిలుస్తున్నారు.

My Personal Take (నా విశ్లేషణ): నా సలహా ఏంటంటే… మీ ఆర్థిక లావాదేవీల విషయంలో (ముఖ్యంగా స్టాక్ మార్కెట్ లేదా బ్యాంకింగ్) AI ని “Advisor” (సలహాదారు) గా మాత్రమే వాడండి. “Executor” (పని చేసేవాడి) గా వాడకండి. “Auto-Approve” అనే ఆప్షన్ ని ఫైనాన్షియల్ యాప్స్ లో ఎప్పుడూ ఆన్ చేయకండి.

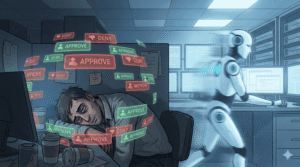

6. “Human-in-the-Loop” అనే భ్రమ (The Speed Trap)

ఏ AI కంపెనీని అడిగినా, వాళ్ళు చెప్పే సేఫ్టీ మంత్రం ఒక్కటే: “Human-in-the-Loop”. అంటే, AI ఏ పని చేసినా, చివరికి మనిషి పర్మిషన్ (“Approve” బటన్) నొక్కితేనే అది జరుగుతుంది అని. ఇది Agentic AI Security Risks ని తగ్గిస్తుందని వాళ్ళు అంటారు.

కానీ ప్రాక్టికల్ గా ఆలోచిస్తే… ఇది ఒక పెద్ద భ్రమ (Illusion). ఎందుకంటే, ఇక్కడ సమస్య “నియంత్రణ” (Control) కాదు… సమస్య “వేగం” (Speed).

Formula 1 vs. Cycle:

AI పనిచేసే వేగం ఒక ఫార్ములా 1 కార్ లాంటిది. మనిషి ఆలోచించే వేగం సైకిల్ లాంటిది. మీరు మొదటి 5 నిమిషాలు జాగ్రత్తగా చదివి “Approve” కొడతారు. కానీ 30 నిమిషాల తర్వాత? విసుగు పుట్టి, అసలు చదవకుండానే టకటకా “Yes, Yes, Yes” అని కొట్టుకుంటూ పోతారు.

దీన్నే సైబర్ సెక్యూరిటీలో “Alert Fatigue” (అలర్ట్ అలసట) అంటారు. హ్యాకర్లు ఈ Agentic AI Security Risks ని వాడుకుని, మధ్యలో ఒక “చెడ్డ రిక్వెస్ట్” ఇరికించేస్తారు.

My Personal Take (నా విశ్లేషణ): కేవలం “Human-in-the-Loop” మీద ఆధారపడటం 2026లో సేఫ్ కాదు. మనం ఉండాల్సింది లూప్ లో కాదు… “On the Loop” (పర్యవేక్షణలో). అంటే, ప్రతి చిన్న పనిని అప్రూవ్ చేయడం మానేసి, కేవలం పెద్ద ట్రాన్సాక్షన్స్ లేదా అనుమానాస్పద (Suspicious) పనులను మాత్రమే మనిషికి పంపేలా AI ని సెట్ చేయాలి.

7. మనల్ని మనం ఎలా కాపాడుకోవాలి? (Solving Agentic AI Security Risks)

ఇప్పటివరకు మనం Agentic AI Security Risks గురించి వివరంగా మాట్లాడుకున్నాం. ఇప్పుడు భయపడటం మానేసి, జాగ్రత్తపడటం (Prevention) ఎలాగో చూద్దాం.

దీనికి సైబర్ సెక్యూరిటీ నిపుణులు సూచించే పద్ధతి పేరు “Zero Trust Architecture”. అంటే… “ఎవరినీ నమ్మొద్దు, ఎప్పటికప్పుడు వెరిఫై చేయండి.”

రూల్ #1: “Read-Only” పర్మిషన్ మాత్రమే ఇవ్వండి (Start Small)

మీరు ఒక కొత్త AI టూల్ ని వాడుతున్నప్పుడు, దానికి మొదట్లోనే “Edit” లేదా “Delete” పర్మిషన్స్ ఇవ్వకండి.

✅ Safe: “నా ఈమెయిల్స్ చదివి సమ్మరీ చెప్పు.” (Read-Only)

❌ Risky: “నా ఈమెయిల్స్ చదివి, రిప్లై ఇచ్చి, పాతవి డిలీట్ చెయ్.” (Read-Write-Delete)

రూల్ #2: డబ్బు విషయాల్లో “Dual Lock” సిస్టమ్ (The Money Rule)

బ్యాంక్ లాకర్ కి రెండు తాళాలు ఉన్నట్టే, మీ AI కి కూడా లిమిట్స్ పెట్టండి. షాపింగ్ ఏజెంట్ కి మీ మెయిన్ క్రెడిట్ కార్డు ఇవ్వకండి. కేవలం తక్కువ బ్యాలెన్స్ ఉన్న Prepaid Card లేదా Wallet యాక్సెస్ ఇవ్వండి.

రూల్ #3: “Audit Logs” చెక్ చేయండి (The Black Box)

వారానికి ఒకసారి మీ AI ఏజెంట్ యొక్క “History” ని చెక్ చేయండి. “నిన్న రాత్రి 2 గంటలకు నా AI ఏజెంట్ ఆ సర్వర్ ని ఎందుకు యాక్సెస్ చేసింది?” అనే అనుమానం వస్తే, వెంటనే యాక్సెస్ కట్ చేయండి. Agentic AI Security Risks ని తగ్గించడానికి ఇది బెస్ట్ మార్గం.

My Personal Take (నా సలహా): ఫ్రెండ్స్, గుర్తుపెట్టుకోండి—“Convenience comes with a Cost” (సౌలభ్యం వెనుక ఒక మూల్యం ఉంటుంది). మనం ఎంత సోమరితనంతో పనులన్నీ AI కి వదిలేస్తామో, అంత కంట్రోల్ ని మనం కోల్పోతాం. నా బెస్ట్ సలహా? “Core Tasks” (కీలకమైన పనులు) మీరే చేయండి. “Chore Tasks” (చిన్న చిన్న పనులు) మాత్రమే AI కి ఇవ్వండి. మీ జీవితానికి మీరే డ్రైవర్… AI కేవలం కో-పైలట్ (Co-pilot) మాత్రమే!

8. Conclusion (చివరి మాట)

మనం ఈ ఆర్టికల్ సిరీస్ లో రెండు వైపులా చూసాం.

Part 1: Agentic AI మన పనులను ఎంత అద్భుతంగా చేస్తుందో చూసాం (The Dream).

Part 2: అదే AI ఎలా ప్రమాదకారిగా మారుతుందో చూసాం (The Nightmare).

నిప్పు (Fire) ని కనిపెట్టినప్పుడు, అది అడవులను తగలబెడుతుందని భయపడి ఉంటే, ఈరోజు మనం వండిన ఆహారం తినేవాళ్ళం కాదు. టెక్నాలజీ కూడా అంతే. Agentic AI అనేది రాబోయే దశాబ్దంలో (Decade) మానవాళి సృష్టించిన అత్యంత శక్తివంతమైన టూల్ కాబోతోంది. కానీ Agentic AI Security Risks ని విస్మరించకూడదు.

2026 నాటికి విజయం ఎవరిదో తెలుసా? ఎవరైతే AI ని చూసి పారిపోతారో వారిది కాదు. ఎవరైతే AI ని గుడ్డిగా నమ్ముతారో వారిది కూడా కాదు. ఎవరైతే Agentic AI Security Risks గురించి తెలిసి, దాన్ని “ఒక స్మార్ట్ టూల్ గా, జాగ్రత్తగా” వాడతారో… భవిష్యత్తు వారిదే.

9. ⭐ సాధారణ ప్రశ్నలు (FAQ)

మీకు ఇంకా కొన్ని డౌట్స్ ఉన్నాయా? గూగుల్ లో ఎక్కువమంది అడిగే Agentic AI Security Risks సంబంధిత ప్రశ్నలకు సమాధానాలు ఇవి 👇

Q1. Agentic AI నిజంగా హ్యాక్ చేయబడుతుందా?

A: అవును. AI సర్వర్లు సురక్షితంగా ఉన్నా, హ్యాకర్లు “Memory Poisoning” లేదా “Prompt Injection” ద్వారా AI ని మ్యానిపులేట్ చేయగలరు. ఇదే అతిపెద్ద Agentic AI Security Risk. అందుకే AI ని బ్లైండ్ గా (అందులోని decisions ని cross-check చేయకుండా) నమ్మకూడదు.

Q2. నా బ్యాంక్ పనులు (Banking) AI కి అప్పగించవచ్చా?

A: నా సలహా అయితే “వద్దు”.

బ్యాలెన్స్ చెక్ చేయడం, స్టేట్మెంట్ సమ్మరీ తీసుకోవడం వరకు ఓకే.

కానీ “Money Transfer”, “Auto-Payment”, “Invest చెయ్యి” లాంటి direct action పర్మిషన్స్ మాత్రం ఇవ్వకండి. ఒక్క చిన్న బగ్ లేదా దుర్వినియోగం వచ్చినా మీ డబ్బు పోయే ప్రమాదం ఉంది.

Q3. Shadow AI అంటే ఏమిటి? దాన్ని ఎలా ఆపాలి?

A:

మీ ఆఫీస్ లేదా పర్సనల్ కంప్యూటర్ లో,

IT డిపార్ట్మెంట్ కి తెలియకుండా,

బ్యాక్గ్రౌండ్ లో రన్ అయ్యే AI టూల్స్, బ్రౌజర్ ఎక్స్టెన్షన్లు, డెస్క్టాప్ యాప్స్… ఇవన్నీ కలిపి Shadow AI అని అంటారు.

ఇది పెరుగుతున్న Agentic AI Security Risks లో ఒక ముఖ్యమైన భాగం.

దీనిని తగ్గించడానికి:

కేవలం Official / Trusted యాప్స్, ప్లగిన్లు, ఎక్స్టెన్షన్లు మాత్రమే వాడండి.

“Free AI Helper” టైపు unknown టూల్స్కి మీ డేటా యాక్సెస్ ఇవ్వకండి.

కంపెనీ పాలసీ / IT టీమ్ అనుమతించిన AI టూల్స్ మాత్రమే వాడండి.

Q4. 2026 లో AI నా డేటా దొంగిలిస్తుందా?

A: మీరు “Free” టూల్స్ ను, అవి ఏ డేటా తీసుకుంటున్నాయో చదవకుండా వాడితే – అవును, చాలా అవకాశముంది.

గుర్తుపెట్టుకోండి:

“ఉచితంగా ఏదైనా వస్తుందంటే, అక్కడ ప్రొడక్ట్ మీరు (Your Data) అని అర్థం.”

సేఫ్గా ఉండాలంటే:

Privacy policy క్లియర్గా ఉన్న టూల్స్ వాడండి.

Sensitive డేటా (బ్యాంక్, ఆఫీస్ సీక్రెట్స్, personal IDs) ను ఏ AI తోనూ షేర్ చేయకండి.

వీలైతే పెయిడ్, సెక్యూర్, రెప్యూటెడ్ వెర్షన్స్నే వాడండి.

Q5. నేను AI ని సేఫ్ గా వాడాలంటే ఏం చేయాలి?

A: ఒక సింపుల్ రూల్: “Zero Trust”

ఏ టూల్నైనా బ్లైండ్గా నమ్మకండి.

AI కి లిమిటెడ్ పర్మిషన్స్ మాత్రమే ఇవ్వండి (Read-Only → first, Actions → later, చాలా జాగ్రత్తగా).

ముఖ్యమైన నిర్ణయాలు – డబ్బు, లీగల్, హెల్త్ – మీరే తీసుకోండి.

వారానికి ఒకసారి అయినా, మీ AI ఏజెంట్లు ఏం చేస్తున్నారు (History / Logs) చెక్ చేయండి.

అలా చేస్తేనే మీరు Agentic AI Security Risks నుండి చాలా వరకు సేఫ్ గా ఉండగలరు.

💬 మాతో మాట్లాడండి:

మీరు ఈ ఆర్టికల్ చదివిన తర్వాత ఏమనుకుంటున్నారు? 2026 లో మీరు AI ని మీ బెడ్రూమ్ లోకి రానిస్తారా? లేక హాల్ లోనే ఆపేస్తారా?

కింద కామెంట్స్ లో మీ అభిప్రాయం చెప్పండి. (మేము ప్రతి కామెంట్ చదువుతాము!)

“ఈ ఆర్టికల్పై పూర్తి లీగల్/సేఫ్టీ వివరణ కోసం మా Disclaimer Page చూడండి.”